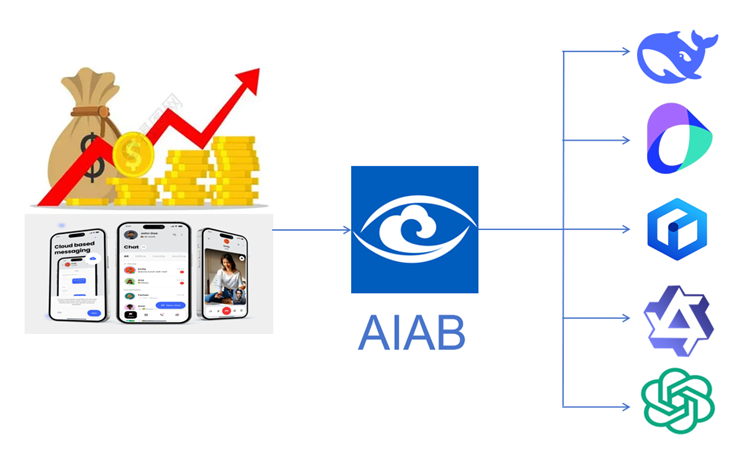

对比评估多个大模型

在大模型(LLM)各种服务场景中,根据大模型在业务中的实际表现,动态调整多个不同模型服务之间的流量分配,从而帮助业务方进行效果最好和(或)成本最低的快速实验,从而保证线上的模型服务效益最大化。

云眼A/B实验(AB Test)提供通用的大模型评测实验能力,提供开箱即用的A/B平台能力。

云眼A/B实验(AB Test)提供是类型扩展能力,客户可以制化自己特殊的大模型实验,为特殊的大模型应用场景提供AB测试。

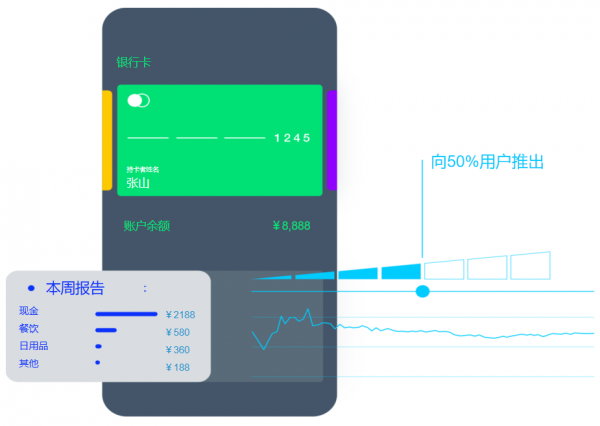

单个大模型调优

对某个单一大模型(LLM)的使用方式,多种方案对比分析,持续不断的优化,获得更好的用户体验和业务效果。

对比测试和优化的元素包括:

- 大模型调用API参数

- Token

- 额外Token或规则的使用

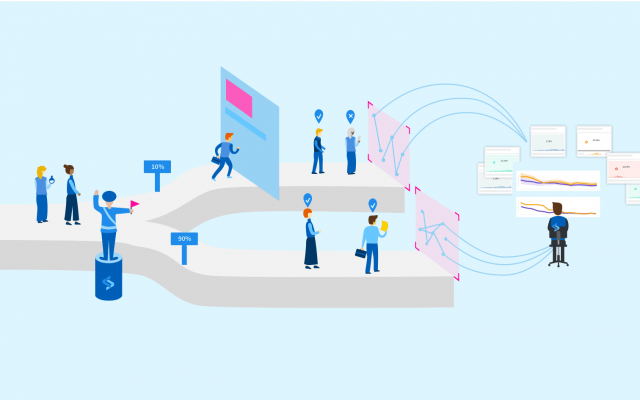

知道什么是有效的

行业领先的统计引擎提供实时实验结果,由我们与清华大学共同开发,实现数据洞察并为大规模业务做出决策。

拼接客户和帐户资料,通过丰富的第一方数据创建整体视图,而不仅仅是网站流量。

- 协调数据

- 统一的客户档案

- 以第一方数据为线索